По определению, интернет-поисковик это система поиска информации, которая помогает нам найти информацию во всемирной паутине. Это облегчает глобальный обмен информацией. Но интернет является неструктурированной базой данных. Он растет в геометрической прогрессии, и стал огромным хранилищем информации. Поиск информации в интернете, является трудной задачей. Существует необходимость иметь инструмент для управления, фильтра и извлечения этой океанической информации. Поисковая система служит для этой цели.

Как работает поисковая система?

Поисковые системы интернета являются двигателями, поиска и извлечения информации в интернете. Большинство из них используют гусеничную архитектуру индексатора. Они зависят от их гусеничных модулей. Сканеры также называют пауками это небольшие программы, которые просматривают веб-страницы.

Сканеры посещают первоначальный набор URL-адресов. Они добывают URL-адреса, которые появляются на просканированных страницах и отправляют эту информацию в модуль гусеничный управления. Гусеничный модуль решает, какие страницы посетить в следующий раз и дает эти URL-адреса сканерам.

Темы, охватываемые различными поисковыми системами, варьируются в зависимости от алгоритмов, которые они используют. Некоторые поисковые системы запрограммированы на поисковые сайты по конкретной теме, в то время как сканеры других могут посещать столько мест, сколько возможно.

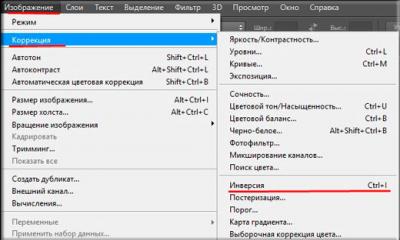

Модуль индексации извлекает информацию из каждой страницы, которую он посещает и вносит URL в базу. Это приводит к образованию огромной таблицы поиска, из списка URL-адресов указывающих на страницы с информацией. В таблице приведены те страницы, которые были покрыты в процессе обхода.

Модуль анализа является еще одной важной частью архитектуры поисковой системы. Он создает индекс полезности. Индекс утилита может предоставить доступ к страницам заданной длины или страниц, содержащих определенное количество картинок на них.

В процессе сканирования и индексирования, поисковик сохраняет страницы, которые он извлекает. Они временно хранятся в хранилище страницы. Поисковые системы поддерживают кэш страниц которые они посещают, чтобы ускорить извлечение уже посещенных страниц.

Модуль запроса поисковой системы получает поисковый запросов от пользователей в виде ключевых слов. Модуль ранжирования сортирует результаты.

Архитектура гусеничного индексатора имеет много вариантов. Они изменяются в распределенной архитектуре поисковой системы. Эти архитектуры состоят из собирателей и брокеров. Собиратели собирают информацию индексации с веб-серверов в то время как брокеры дают механизм индексирования и интерфейс запросов. Брокеры индексируют обновление на основе информации, полученной от собирателей и других брокеров. Они могут фильтровать информацию. Многие поисковые системы сегодня используют этот тип архитектуры.

Поисковые системы и ранжирования страниц

Когда мы создаем запрос в поисковой системе, результаты отображаются в определенном порядке. Большинство из нас, как правило, посещают страницы верхнего порядка и игнорируют последние. Это потому, что мы считаем, что верхние несколько страниц несут большую актуальность для нашего запроса. Так что все заинтересованы в рейтинге своих страниц в первых десяти результатов в поисковой системе.

Слова, указанные в интерфейсе запроса поисковой системы являются ключевыми словами, которые запрашивались в поисковых системах. Они представляют собой список страниц, имеющих отношение к запрашиваемым ключевым словам. Во время этого процесса, поисковые системы извлекают те страницы, которые имеют частые вхождений этих ключевых слов. Они ищут взаимосвязи между ключевыми словами. Расположение ключевых слов также считается, как и рейтинг страницы, содержащие их. Ключевые слова, которые встречаются в заголовках страниц или в URL, приведены в больший вес. Страницы, имеющие ссылки, указывающие на них, делают их еще более популярными. Если многие другие сайты, ссылаются на какую либо страницу, она рассматривается как ценная и более актуальная.

Существует алгоритм ранжирования, который использует каждая поисковая система. Алгоритм представляет собой компьютеризированную формулу разработанную, чтобы предоставлять соответствующие страницы по запросу пользователя. Каждая поисковая система может иметь различный алгоритм ранжирования, который анализирует страницы в базе данных двигателя, чтобы определить соответствующие ответы на поисковые запросы. Различные сведения поисковые системы индексируют по-разному. Это приводит к тому, что конкретный запрос, поставленный двум различным поисковым машинам, может принести страницы в различных порядках или извлечь разные страницы. Популярность веб-сайта являются факторами, определяющими актуальность. Клик-через популярность сайта является еще одним фактором, определяющим его ранг. Это мера того, насколько часто посещают сайт.

Веб-мастера пытаются обмануть алгоритмы поисковой системы, чтобы поднять позиции своего сайта в поисковой выдаче. Заполняют страницы сайта ключевыми словами или используют мета теги, чтобы обмануть стратегии рейтинга поисковой системы. Но поисковые системы достаточно умны! Они совершенствуют свои алгоритмы так, чтобы махинации веб-мастеров не влияли на поисковую выдачу.

Нужно понимать, что даже страницы после первых нескольких в списке могут содержать именно ту информацию, которую вы искали. Но будьте уверены, что хорошие поисковые системы всегда принесут вам высоко релевантные страницы в верхнем порядке!

В последние годы сервисы от «Гугл» и «Яндекс» прочно вошли в нашу жизнь. В этой связи многие наверняка задаются вопросом, что такое поисковая система? Говоря простыми словами, это программная система, предназначенная для поиска информации в World Wide Web. Результаты его обычно представлены в виде списка, часто называемом страницами результатов поиска (SERP). Информация может представлять собой сочетание веб-страниц, изображений и других типов файлов. Некоторые поисковые системы также содержат информацию, доступную в базах данных или открытых каталогах.

В отличие от веб-каталогов, которые поддерживаются только собственными редакторами, поисковики также содержат информацию в режиме реального времени, запуская алгоритм на веб-искателе.

История возникновения

Сами по себе поисковые системы появились ранее всемирной сети - в декабре 1990 года. Первый такой сервис назывался Archie, и он искал по командам содержимое файлов FTP.

Что такое поисковая система в Интернете? До сентября 1993 года World Wide Web была полностью проиндексирована вручную. Существовал список веб-серверов, отредактированный Тимом Бернерс-Ли, который был размещен на веб-сервере CERN. По мере того, как все большее количество серверов выходили в интернет, вышеуказанный сервис не мог успевать обрабатывать такое количество информации.

Одной из первых поисковых систем, основанных на поиске в сети, была WebCrawler, которая вышла в 1994 году. В отличие от своих предшественников, она позволяла пользователям искать любое слово на любой веб-странице. Такой алгоритм с тех пор стал стандартом для всех основных поисковых систем. Это было также первое решение, широко известное публике. Также в 1994 году был запущен сервис Lycos, который впоследствии стал крупным коммерческим проектом.

Вскоре после этого появилось много поисковых машин, и их популярность значительно выросла. К ним можно отнести Magellan, Excite, Infoseek, Inktomi, Northern Light и AltaVista. Yahoo! был одним из самых популярных способов отыскания интересующих веб-страниц, но его алгоритм поиска работал в своем собственном веб-каталоге, а не в полнотекстовых копиях страниц. Искатели информации также могли просматривать каталог, а не выполнять поиск по ключевым словам.

Новый виток развития

Компания Google приняла идею продажи поисковых запросов в 1998 году, начиная с небольшой компании goto.com. Этот шаг оказал значительное влияние на бизнес SEO, который со временем стал одним из самых прибыльных занятий в Интернете.

Примерно в 2000 году поисковая система «Гугл» стала широко известна. Компания добилась лучших результатов для многих поисков с помощью инноваций под названием PageRank. Этот итерационный алгоритм оценивает веб-страницы на основе их связей с другими сайтами и страницами, исходя из предпосылки, что хорошие или желанные источники часто упоминаются другими. Google также поддерживал минималистский интерфейс для своей поисковой системы. Напротив, многие из конкурентов встроили поисковую систему в веб-портал. На самом деле «Гугл» стала настолько популярной, что появились мошеннические движки, такие как Mystery Seeker. Сегодня существует масса региональных версий этого сервиса, в частности, поисковая система Google.ru, рассчитанная на русскоязычных пользователей.

Как работают эти сервисы?

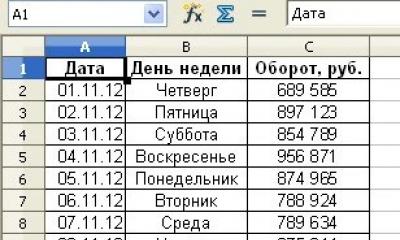

Как же происходит ранжирование и выдача результатов? Что такое поисковые системы с точки зрения алгоритма действий? Они получают информацию через веб-сканирование с сайта на сайт. Робот или «паук» проверяет стандартное имя файла robots.txt, адресованное ему, перед отправкой определенной информации для индексации. При этом основное внимание уделяется многим факторам, а именно заголовкам, содержимому страницы, JavaScript, каскадным таблицам стилей (CSS), а также стандартной разметке HTML информационного содержимого или метаданным в метатегах HTML.

Индексирование означает связывание слов и других определяемых токенов, найденных на веб-страницах, с их доменными именами и полями на основе HTML. Ассоциации создаются в общедоступной базе данных, доступной для запросов веб-поиска. Запрос от пользователя может быть одним словом. Индекс помогает найти информацию, относящуюся к запросу как можно быстрее.

Некоторые из методов индексирования и кэширования - это коммерческие секреты, тогда как веб-сканирование - это простой процесс посещения всех сайтов на систематической основе.

Между посещениями робота кэшированная версия страницы (часть или весь контент, необходимый для ее отображения), хранящийся в рабочей памяти поисковой системы, быстро отправляется запрашивающему пользователю. Если визит просрочен, поисковик может просто действовать как веб-прокси. В этом случае страница может отличаться от индексов поиска. На кэшированном источнике отображается версия, слова которой были проиндексированы, поэтому он может быть полезен в том случае, если фактическая страница была утеряна.

Высокоуровневая архитектура

Обычно пользователь вводит запрос в поисковую систему в виде нескольких ключевых слов. У индекса уже есть имена сайтов, содержащих данные ключевые слова, и они мгновенно отображаются. Реальная загрузочная нагрузка заключается в создании веб-страниц, которые являются списком результатов поиска. Каждая страница во всем списке должна быть оценена в соответствии с информацией в индексах.

В этом случае верхний элемент результата требует поиска, реконструкции и разметки фрагментов, показывающих контекст из сопоставленных ключевых слов. Это лишь часть обработки каждой веб-страницы в результатах поиска, а дальнейшие страницы (рядом с ней) требуют большей части этой последующей обработки.

Всё дело в универсальности: невозможно одинаково хорошо искать в блогах и в научных статьях, в цифровых изображениях и кулинарных рецептах. Именно поэтому существует множество не столь известных специализированных поисковых систем, которые работают исключительно с какой-то одной категорией данных, но делают это на высочайшем уровне.Более того, многое из находимого такими поисковиками вообще невозможно отыскать при помощи Google и других универсальных систем: они просто не видят такую информацию, которая к тому же нередко умышленно закрыта для подобных «веб-пауков». Поговорим о нескольких таких «узких профессионалах», способных, возможно, открыть для вас ту сторону интернета, о которой вы и не подозревали.

1. Поиск среди удалённых из Google и заблокированных страниц

Не для кого не секрет, что правительства многих стран пытаются повлиять на то, какой сетевой контент доступен на территории их государств. Это может объясняться как чисто политическими соображениями, так и требованиями законодательства о противодействии терроризму и детской порнографии и, конечно же, влиянием лоббистов крупных правообладателей. Критерии запретов могут быть как вполне разумными, так и совершенно произвольными: всё зависит и от общего состояния правосознания в стране, и от вменяемости самих правоохранителей.

Поисковая система Google в большинстве случаев идёт навстречу мотивированным требованиям национальных правительств и удаляет из результатов поисковой выдачи сайты и страницы, доступ к которым через локализованные версии поисковика должен быть запрещён. Между тем удаление адреса из результатов поиска Google и даже блокировка URL и IP-адреса на уровне местного провайдера вовсе не означает, что такой ресурс исчез из интернета или больше недоступен.

Классическое средство обхода подобных ограничений — браузер Tor, основанный на системе альтернативной обычной «луковой» маршрутизации. Один из новейших пакетов, включающих в себя клиент Tor (Vidalia) и браузер Firefox Portable c расширением foxyproxy, носит вполне «говорящее» название PirateBrowser.

От других подобных пакетов он отличается тем, что не предназначен для полностью анонимного сёрфинга: PirateBrowser использует сеть Tor исключительно для обхода местных блокировок тех или иных страниц и сайтов, подставляя произвольные IP-адреса вместо настоящих. С его помощью вы можете зайти на заблокированную страницу, если уже знаете её адрес, либо поискать её, например, через основной сайт Google.com или какие-то другие его локальные версии.

В PirateBrowser уже встроены настройки для некоторых стран, включая Иран, Северную Корею, а также (сюрприз!) Великобританию, Нидерланды, Бельгию, Финляндию, Данию, Италию и Ирландию. Разумеется, ничто не мешает внести в систему и собственные настройки. К сожалению, в отличие от «полноценного» Tor, PirateBrowser доступен только в версии для Windows.

2. Поиск среди несуществующих версий страниц

Многие из нас пользовались кешем Google или «Яндекса», чтобы посмотреть недавно изменённую или удалённую страницу в том виде, в каком она была изначально опубликована в Сети. Обычно такой кеш доступен в поисковой выдаче довольно короткое время, ведь поисковый робот настроен на отслеживание и учёт всех изменений, чтобы выдавать наиболее актуальную версию интернет-ресурса.

Поэтому, если вы хотите знать, как выглядел тот или иной сайт месяц, год, а тем более несколько лет назад, вам придётся воспользоваться другим средством, а именно веб-сервисом «Архива Интернета», который носит название Wayback Machine, то есть что-то вроде «Машины времени». Некоммерческая организация «Архив Интернета» с 1997 года собирает копии веб-страниц, мультимедийный контент и программное обеспечение, размещаемое в Сети, и делает эти копии доступными бесплатно для всех желающих. При помощи Wayback Machine вы сможете найти не только версию знакомого вам сайта многолетней давности, но и даже те страницы, которых давно не существуют и которые попросту удалены из «обычного» интернета. На сегодня в архиве присутствует около 366 миллиардов страниц, и очень велика вероятность того, что среди них окажется та, что нужна именно вам.

3. Поиск изображений

Самый распространённый способ найти какую-то картинку — это, конечно же, воспользоваться Google Images. А как быть, если вы всё-таки не смогли найти подходящее изображение привычными средствами? Можно, к примеру, попробовать специализированный сервис Picsearch, в котором, как утверждают его создатели, проиндексировано больше трёх миллиардов цифровых картинок.

У Picsearch есть не только многоязычный пользовательский интерфейс, но и полноценный многоязычный поиск, а также несколько полезных фильтров, включая поиск только чёрно-белых или цветных изображений, картинок с преобладанием какого-то конкретного цвета, поиск «обоев» для рабочего стола, а также лиц или анимированных изображений.

Гораздо меньшим объёмом заявленной проиндексированной базы может похвастаться поисковая система Everystockphoto: она содержит более 20 миллионов изображений, хранящихся на онлайновых фотосайтах, включая Flickr, Fotolia и Wikimedia Commons. Тем не менее результаты её работы весьма впечатляют. Большинство из найденных снимков можно использовать бесплатно, но с условием указания имени фотографа или правообладателя.

4. Вычислительно-поисковая система

Как известно, поисковая система Google умеет проводить несложные вычисления, конвертировать из одних единиц в другие и делать некоторые другие полезные вещи, не связанные непосредственно с поиском. Однако если вам нужны ответы на действительно сложные вопросы в области математики, физики, медицины, статистики, истории, лингвистики и других областей науки, то вам не обойтись без «вычислительно-поисковой системы» WolframAlpha, способной предложить пользователю чуть ли не энциклопедические ответы на самые необычные вопросы.

Фактически это даже не совсем поисковая система, а огромная база данных, часть которой преобразована в вычислительные алгоритмы, что и позволяет получать готовые сведения о том, сколько граммов протеина содержится в десятке конфеток M&M’s, какова ожидаемая средняя продолжительность жизни в США, Швеции и Японии в текущем году или как решается алгебраическое уравнение.

5. Поиск людей

Казалось бы, найти человека в интернете, зная его имя и фамилию, проще простого. Да, если это какая-то знаменитость, кинозвезда, спортсмен или постоянный пользователь социальных сетей. Тогда первая же страница результатов поиска Google даст вам практически исчерпывающую информацию о том, кто это такой и чем занимался в последнее время. Если же тот, кого вы ищете, не жаждет широкой популярности и не увлекается сетевым эксгибиционизмом, найти информацию о нём в интернете будет не так просто.

В этом случае можно попробовать поисковую систему Pipl, которая осуществляет поиск людей в целом ряде публичных реестров, онлайновых баз данных, служб и всё-таки в социальных сетях, в том числе и профессиональных. В отличие от большинства подобных сервисов, Pipl работает и с кириллицей, так что он вполне работоспособен и с русскоязычными фамилиями.

Отечественный сервис SpravkaRU.NET поможет обнаружить адрес и домашний телефон жителя России, Украины, Беларуси, Казахстана, Латвии и Молдовы. Этот сайт представляет собой электронный телефонный справочник некоторых крупных городов перечисленных стран, но, увы, далеко не полный.

Больше шансов найти жителей Москвы или Санкт-Петербурга, причём только тех, на кого оформлен домашний номер. В отличие от альтернативных сервисов, SpravkaRU.NET содержит вполне актуальные базы, и если вы располагаете хотя бы некоторой информацией о родственниках или примерном месте проживания разыскиваемого, то он способен помочь вам установить его телефон и адрес.

6. Поиск научной информации

Если вы занимаетесь наукой и хотите найти свежие научные публикации по вашей теме в Google, то вам нужно срочно забыть об открытиях и заняться чем-то менее интеллектуальным. В Google вы сможете обнаружить лишь ссылки на отдельные работы, опубликованные на каких-то общедоступных сайтах вроде Википедии. В действительности практически все научные статьи хранятся на веб-серверах, относящихся к категории так называемого глубокого Веба, который по различным причинам недоступен для универсальных поисковых систем.

Всё дело в принудительном запрете на индексацию каких-либо данных, которые хотя и не относятся к секретным, но составляют некую служебную информацию или не представляют интереса для широкой публики. Это и библиотечные каталоги, и медицинские или транспортные базы данных, и каталоги всевозможной промышленной продукции. «Пауки» не могут обойти систему обязательной регистрации или ограничения доступа, поэтому в результатах выдачи Google вы редко увидите научные материалы, попросту непонятные людям, которые не занимаются аналогичными исследованиями.

Приоткрыть дверь в научный «глубокий веб» способен специализированный поисковик CompletePlanet, имеющий доступ более чем к 70 000 научных баз данных и узконаправленных поисковых систем.

«Если люди не могут найти что-то в Google, они думают, что это не сможет найти никто. Это не так», – утверждает Джон Мэзерли, создатель Shodan, самого страшного поискового движка Интернета.

В отличие от Google, который ищет в Сети простые сайты, Shodan работает с теневыми каналами Интернета. Это своего рода «черный» Google, позволяющий искать серверы, веб-камеры, принтеры, роутеры и самую разную технику, которая подключена к Интернету и составляет его часть.

Shodan работает 24 часа в сутки 7 дней в неделю, собирая информацию о 500 млн подключенных устройствах и услугах ежемесячно.

Просто невероятно, чтó можно найти в Shodan с помощью простого запроса. Бесчисленные светофоры, камеры безопасности , домашние системы автоматизации, системы отопления – все это подключено к Интернету и легко обнаруживается.

Пользователи Shodan нашли системы управления аквапарка , газовой станцией, охладителя вина в отеле и крематория. Специалисты по кибербезопасности с помощью Shodan даже обнаружили командно-контрольные системы ядерных электростанций и ускорителя атомных частиц .

И особенно примечателен в Shodan с его пугающими возможностями тот факт, что очень немногие из упомянутых систем имеют хоть какую-то систему безопасности.

«Это гигантское фиаско в безопасности», – говорит Эйч-Ди Мур, директор по безопасности в Rapid 7. Эта компания имеет частную базу данных типа Shodan для собственных исследовательских задач.

Если сделать простой поиск по запросу «default password», можно найти бесконечное число принтеров, серверов и систем управления с логином «admin» и паролем «1234». Еще больше подключенных систем вообще не имеют реквизитов доступа – к ним можно подключиться с помощью любого браузера.

Независимый специалист по проникновению в системы Дэн Тентлер в прошлом году на конференции по кибербезопасности Defcon продемонстрировал, как он с помощью Shodan нашел системы управления испарительными охладителями, нагревателями воды с давлением и гаражными воротами.

Он нашел автомойку, которую можно включать и выключать, и ледовую арену в Дании, которую можно разморозить одним нажатием кнопки. В одном городе к Интернету была подключена целая система управления дорожно-транспортной сетью, и всего одной командой ее можно было перевести в «тестовый режим». А во Франции он нашел систему управления гидроэлектростанцией с двумя турбинами, каждая из которых генерирует по 3 мегаватт.

Страшные вещи, если попадут не в те руки.

«Этим можно нанести серьезный вред», – сказал Тентлер, и он еще мягко выразился.

Так почему же все эти устройства подключены к сети и почти не защищены? В некоторых случаях, таких как дверные замки с управлением через iPhone, принято считать, что их очень сложно найти. И тогда о безопасности думают по остаточному принципу.

Более серьезной проблемой является то, что многие такие устройства вообще не должны быть в онлайне. Фирмы часто покупают устройства, которые позволяют с помощью компьютера управлять, скажем, системой нагревания. Как подключить компьютер к системе нагревания? Вместо прямого подключения во многих ИТ-отделах просто подключают и то, и другое к веб-серверу, тем самым неосознанно раскрывая их всему миру.

«Конечно, на таких вещах просто нет безопасности, – говорит Мэзерли. – Но в первую очередь им не место в Интернете».

Но хорошо то, что Shodan почти полностью используется для благих целей.

Сам Мэзерли, который три года назад создал Shodan просто забавы ради, ограничил число запросов до 10 без учетной записи и 50 с учетной записью. Если вы хотите задействовать больше возможностей Shodan, Мэзерли запросит у вас дополнительную информацию о ваших целях – и оплату.

Испытатели проникновения, специалисты по безопасности, научные исследователи и правоохранительные органы – вот основные пользователи Shodan. Мэзерли согласен с тем, что Shodan могут воспользоваться как отправной точкой и плохие ребята. Но он при этом добавляет, что киберпреступники обычно имеют доступ к ботнетам – большим коллекциям инфицированных компьютеров, которые могут делать то же самое, но скрытно.

Сегодня большинство кибератак сосредоточены на краже денег и интеллектуальной собственности. Плохие ребята пока еще не пытались навредить кому-то, взорвав здание или отключив светофоры.

Специалисты по безопасности надеются предотвратить подобные сценарии, выявляя эти незащищенные подключенные устройства и услуги с помощью Shodan и предупреждая их владельцев об уязвимостях. А тем временем масса вещей в Интернете без всякой безопасности просто сидят и ждут атаки.

Для того чтобы осуществить продвижение сайта, необходимо понимать как работают поисковые системы и что нужно делать, чтобы попасть в позиции поиска по ключевым словам.

Что такое поисковые системы, и какие их задачи

Поисковые системы представляют собой компьютерных роботов, предоставляющих посетителям самую актуальную и наиболее полезную информацию по их запросам.

Чем более правильный ответ дает поисковик, тем более высокий уровень доверия к нему возникает у пользователей сети Интернет.

Это важно для самой системы из-за того, что она из этого получает выгоду в виде прибыли за размещения , которую видят все, кто ею пользуются.

Для того чтобы предоставить правильные ответы, тем самым увеличив количество , поисковики работают по определенному принципу, заключающемуся в сборе данных о постоянно появляющихся сайтах и индексации их страниц.

Принцип работы поисковиков

Многие пользователи сети Интернет считают, что поисковые системы выдают им информацию обо всех сайтах, которые существуют. Но на самом деле это совершенно не так, ведь они ориентируются только на те страницы, которые находятся в базе данных машины поиска. Если сайта в поисковых систем нет, то ни Google, ни Яндекс не выдадут его в поиске.

Многие пользователи сети Интернет считают, что поисковые системы выдают им информацию обо всех сайтах, которые существуют. Но на самом деле это совершенно не так, ведь они ориентируются только на те страницы, которые находятся в базе данных машины поиска. Если сайта в поисковых систем нет, то ни Google, ни Яндекс не выдадут его в поиске.

Когда сайта появляется базе данных, роботы поисковика сканируют его, выявляя все внутренние страницы, а также ссылки, размещенные на данном Интернет-портале. Таким образом, происходит сбор полной информации, как о конкретном сайте, так и других ресурсах, которые он популяризует.

Происходить процесс поимки и систематизации информации посредством . В некоторых случаях это не происходит достаточно долгое время, поэтому необходимо понимать, что это за функция поисковой системы и каким образом она работает.

Какая роль правильного оформления текста на сайте, читайте в нашей .

Итоги

Для того чтобы раскрутить сайт, необходимо учитывать все аспекты работы популярных поисковиков, подстраивая показатели своего Интернет-ресурса под требования данных систем. Если все будет сделано в соответствии с правилами, установленными Google и Яндекс, в скором времени можно будет увидеть свой сайт на первых позициях поиск по ключевым словам.